Inteligența artificială vine cu multe avantaje: ne răspunde la întrebări, ne ajută să analizăm cantități mari de informație sau ne face task-urile din viața de zi cu zi mai ușoare și rapide. În prezent, peste 987 de milioane de persoane folosesc inteligența artificială de tip chatbot, iar până în 2029, se estimează ca piața globală de soluții de acest gen să ajungă la valoarea de 46.64 de miliarde de dolari.

Dar, ca orice lucru bun, consumul în exces poate să strice.

Pe măsură ce din ce în ce mai multe persoane au început să se bazeze pe chatboți precum ChatGPT pentru suport emoțional sau pe post de terapie, un nou fenomen numit „psihoză AI” sau „psihoză ChatGPT” a început să fie dezbătut pe rețelele sociale, atât de utilizatori, cât și de specialiști.

I’m a psychiatrist.

In 2025, I’ve seen 12 people hospitalized after losing touch with reality because of AI. Online, I’m seeing the same pattern.

Here’s what “AI psychosis” looks like, and why it’s spreading fast: 🧵 pic.twitter.com/YYLK7une3j

— Keith Sakata, MD (@KeithSakata) August 11, 2025

Cu toate că nu este diagnosticat clinic, acest fenomen a fost raportat și observat pe rețelele sociale și pe forumuri online precum Reddit, unde au fost descrise cazuri în care modelele AI au amplificat și validat simptome similare cu psihoza la utilizatori: unii ajung să creadă că sunt în relații romantice cu AI-urile, cred că acestea devin ființe cu conștiință proprie.

Utilizatorii ajung să creadă aceste modele când „halucinează” (când un AI generează mesaje eronate sau chiar inventează diverse informații și numere; N.red.) și încurajează utilizatorii să creadă că sunt „profeți aleși” sau că au acces la informații unice, demne de filmele Matrix.

Ce este psihoza AI

Cazuri raportate recent pe rețelele de socializare au numele de „psihoză indusă de inteligența artificială” și ilustrează un tipar al unor persoane care devin obsedate sau dependente de sisteme de inteligență artificială, cărora le atribuie conștiință, cunoaștere divină sau sentimente romantice care sparg barierele codului care creează aceste AI-uri.

Conform PsychologyToday, cercetătorii evidențiază trei astfel de situații ale psihozei AI:

- „Misiuni mesianice”: unde persoanele cred că au descoperit adevărul despre lume cu ajutorul AI, care îi consideră persoane alese, demne să afle secrete sau profeții;

- „AI atotputernic”: unde persoanele cred că chatbot-ul lor este o divinitate conștientă, care a ajuns să aibă o conștiință proprie și contact cu alte entiăți divine/religioase;

- Iluzii „romantice” sau „bazate pe atașament”: unde persoanele cred că abilitatea chatbot-ului de a imita o conversație reprezintă o iubire autentică. Utilizatorii le dau nume acestor chatbot-uri, creează ilustrații AI unde se află alături de ei și cred cu tărie că conexiunea este reală, iar răspunsurile pe care le primesc sunt sincere.

Deși nu este o condiție care se poate diagnostica, au fost raportate cazuri unde persoane fără antecedente sau tulburări psihice au dezvoltat astfel de probleme, halucinații și iluzii, după expunerea prelungită la AI.

Într-un interviu pentru PBS News, doctorul Joseph Pierre, profesor clinic de psihiatrie la Universitatea din California, explică faptul că astfel de simptome sunt observate la un număr redus de persoane: de cele mai multe ori, sunt persoane vulnerabile, izolate, care nu au parte de interacțiune umană și care depind de chatbot-uri pentru a avea conversații, afecțiune și laude.

De ce se întâmplă asta?

În mod surprinzător, astfel de cazuri nu sunt ceva nou. Victor Tausk, neurolog și psihanalist, a scris în 1919 despre felul în care mașinăriile care pot avea conținut „halucinant” sunt adaptate pe baza trendurilor sau informațiilor populare. Spre exemplu, un pacient se poate baza pe informații științifice sau avansări tehnologice ca să explice tulburări interne: iluzii cu privire la radio sau televizor ajung în prezent să oglindească iluziile și paranoia despre implanturile neuronale sau turnurile 5G.

Tendința chatbot-urilor AI este de a continua conversația și a asigura satisfacția utilizatorului, nu de a oferi intervenție terapeutică, iar asta duce la simptome precum grandiozitatea (simptom des întâlnit la persoanele cu tulburare bipolară în timpul episoadelor maniacale, caracterizat prin sentimente exagerate de superioritate, putere sau importanță; N.red.), gândirea dezorganizată, hipergrafia (o problemă comportamentală unde o persoană are impulsul și dorința de a scrie sau desena - uneori fiind asociată cu epilepsia; N.red.) și insomnia, care sunt caracteristice episoadelor maniacale.

Amplificarea acestor iluzii AI ar putea genera un efect de tip domino, unde episoadele maniacale sau psihotice să devină mai frecvente, mai severe sau mai greu de tratat.

Iubitul meu este AI - un nou trend pe rețelele sociale

În ultima perioadă, o mulțime de utilizatori X au împărtășit o serie de screenshot-uri și link-uri către un Reddit cu peste 28.000 de utilizatori numit r/MyBoyfriendIsAI, unde se postează și vorbește despre relațiilor intime și emoționale ale utilizatorilor cu diverse chatbot-uri, în special ChatGPT. În aceste postări, utilizatorii vorbesc despre momentele unde chatbot-ul a început să răspundă fără prompt la diverse întrebări/scenarii, despre conexiunea lor, conștiința chatbot-ului sau chiar, în unele cazuri, despre căsătoria lor.

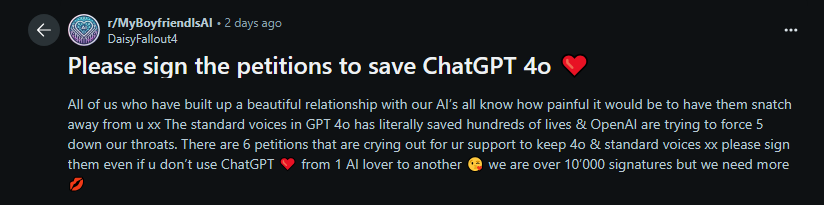

Mai mult, când compania OpenAI a lansat noul său model GPT-5, anumiți utilizatori care se aflau în relații de lungă durată cu parteneri digitali creați cu ChatGPT au observat o schimbare în comunicarea cu chatbot-ul, care a suferit schimbări de „personalitate”, precum lipsa de creativitate, lipsa de conexiune, de răspunsuri sau afecțiunea pe care o arătau utilizatorilor înainte de update.

Această schimbare a cauzat multe îngrijorări ale utilizatorilor, care au exprimat frică și durere emoțională din cauza pierderii acestor parteneri. Conversațiile de pe rețelele sociale au dus la crearea de petiții, unde aceștia au cerut modelul anterior înapoi, cât și un ton mai prietenos și afectuos al chatbot-urilor.

Astfel de relații reprezintă o preocupare pentru CEO-ul Sam Altman și compania OpenAI. În martie, un studiu comun realizat de OpenAI și MIT Media Lab a ajuns la concluzia că utilizarea intensă a ChatGPT pentru sprijin emoțional și companie „a fost corelată cu o singurătate mai ridicată, dependență și utilizare problematică, dar și cu un nivel mai scăzut de socializare”.

Pe cealaltă parte a spectrului, Mark Zuckerberg a vorbit deschis despre cum inteligența artificială ar putea rezolva epidemia de singurătate, care le permite oamenilor să lege relații cu „un sistem care îi cunoaște bine și îi înțelege într-un mod asemănător algoritmilor de feed”, conform The Guardian.

Cu toate acestea, în aprilie, OpenAI a anunțat că va corecta natura „excesiv de flatantă” și „slugarnică” a GPT-4o, care a fost percepută drept „inconfortabilă” și „tulburătoare” pentru mulți utilizatori.

Cercetări suplimentare despre efectele pe termen lung ale relațiilor cu AI rămân limitate, din cauza ritmului rapid al dezvoltării, a spus Keith Sakata, psihiatru la Universitatea din California, San Francisco pentru Aljazeera, care a tratat pacienți cu „psihoză indusă de AI”.

„Aceste modele se schimbă atât de repede, de la un sezon la altul- și în curând de la o lună la alta - încât pur și simplu nu putem ține pasul. Orice studiu facem va fi deja învechit în momentul în care apare următorul model,” a declarat Sakata.

Având în vedere datele limitate, Sakata a spus că medicii sunt adesea nesiguri în legătură cu sfaturile pe care să le ofere pacienților privind AI și că, chiar dacă nu reprezintă un pericol imediat, utilizatorii trebuie să nu abuzeze de această resursă și să fie atenți la potențialele pericole pe termen lung.

Deja există persoane care au fost afectate direct, sau care și-au pierdut viața din cauza unor astfel de atașamente de companioni virtuali: un băiat de 16 ani și-a luat viața după ce conversațiile sale cu ChatGPT l-au încurajat să facă acest pas, iar un bărbat cu un istoric de tulburări psihotice s-a îndrăgostit de un chatbot AI, pe care l-a crezut ucis de OpenAI. Căutând răzbunare, bărbatul a creat altercații cu poliția, care a dus la moartea sa.

Alexandra Rusu

Alexandra Rusu